Was ist Technik? Eine Auseinandersetzung mit dem Technikkonzept von Ernst Kapp

Im vorliegenden Artikel geht es um die Anwendung des Technikkonzepts von Ernst Kapp auf die heutige Technik. Eines der Gebiete, dessen Entwicklung für die Moderne unentbehrlich ist, ist die Computertechnik. Wobei ich einen breit gefächerten Computerbegriff benutzen möchte. Computer werden immer universeller und können immer mehr Aufgaben ausführen, deswegen sind sie bereits ein Teil vieler Bereiche unseres Daseins. Sie werden vorprogrammiert, um anhand gegebener Daten bestimmte Aktionen auszuführen. In diesem Sinne ist nicht nur ein Laptop ein Computer, sondern auch ein Handy; genauso ist ein Roboter ein komplexer Computer.

Datenverarbeitung. Mensch und Maschine

Ein Computer ist vor allem ein Rechner. Es kommt einem so vor, als ob die Computer ganz verschiedene Informationsarten verwalten, bearbeiten und speichern können: Text, Musik, Bilder.

Trotzdem ist ein Computer ein Gerät, das Probleme durch Berechnungen löst: Er kann nur diejenigen Sachverhalte „verstehen“, die man in Form von Zahlen und mathematischen Formeln darstellen kann. Dass es sich dabei heute auch um Bilder, Töne, Animationen, 3-D-Welten oder Filme handeln kann, liegt einfach an der enormen Rechengeschwindigkeit und Kapazität moderner Rechner.1

Natürlich ist das nicht die grundlegendste Ebene: der Arbeitsspeicher und Prozessor wissen nichts von den Zahlen und der Arithmetik, aber die Mathematik ist trotzdem von fundamentaler Bedeutung für die logische Funktionsweise von Programmen.

Darstellung der Daten im Computer. Zahlensysteme und das Zählen

Wenn man einen Text, ein Musikstück oder ein Bild speichern will, werden sie als eine Zahlenfolge interpretiert, und nicht eine Folge von Buchstaben, Noten oder Farben, wie sie für den Menschen erscheinen. Ein wichtiger Unterschied zum vom Menschen eingesetzten dezimalen Zahlensystem ist, dass für das Programmieren der Computer ein binäres Zahlensystem verwendet wird. Für das Rechnen verwenden wir ein Zahlensystem mit 10 Ziffern, von 0 bis 10, daher der Name „dezimal“. Das binäre Zahlensystem hat nur 2 Ziffern: 0 und 1, funktioniert aber wie ein dezimales oder jedes andere Zahlensystem, und lässt sich in jedes andere Zahlensystem übersetzen. Beim Zählen um eine Nummer größer als 9 zu erzeugen, setzt man sie aus mehreren Ziffern zusammen.

| Ziffern des Dezimalsystems | |||||||||

|---|---|---|---|---|---|---|---|---|---|

| 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 |

| Ziffern des Binärsystems | |

|---|---|

| 0 | 1 |

Im binären Zahlensystem ist es genauso mit dem Unterschied, dass die zusammengesetzten Nummern bereits nach 1 folgt, weil es keine 2 gibt, so zählt man folgendermaßen: 0, 1, 10, 11, 100, 101, 110, 111 und so weiter. Jeder Zahl in dieser Folge kann man eine dezimale Zahl zuordnen: 0 ist 0, 1 ist 1, 10 ist 2, 11 ist 3, 100 ist 4 und so weiter.

| Zuordnung | ||||||||||

|---|---|---|---|---|---|---|---|---|---|---|

| Dezimal | 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | |

| Binär | 0 | 1 | 10 | 11 | 100 | 101 | 110 | 111 | 1000 | |

| Dezimal | 9 | 10 | 11 | 12 | 13 | 14 | 15 | 16 | 17 | |

| Binär | 1001 | 1010 | 1011 | 1100 | 1101 | 1110 | 1111 | 10000 | 10001 | |

Das dezimale Zahlensystem ist kaum etwas Eingeborenes, wir hätten auch binär, oktal oder hexadezimal rechnen können, aber die Wahl des Zahlensystems ist auch nicht zufällig. Kapp argumentiert, dass der Wahl des Zahlensystems die Tatsache zugrunde liegt, dass Menschen ihre Finger zum Zählen verwendeten und auch bis heute verwenden:

Der Ausdruck für die Menge der Maßeinheiten derselben Art, die Zahl, wurde, wie noch heute zur Unterstützung des Zählens geschieht, an den fünf Fingern abgezählt. Das griechische Wort für dieses Zählen nach Fünfen war πεµπάζειν, „fünfern“. Die zehn Finger lieferten das Dezimalsystem und die zehn Finger mit Zugabe der beiden Hände des Duodezimalsystem.2

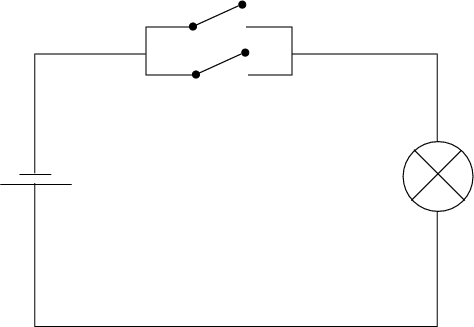

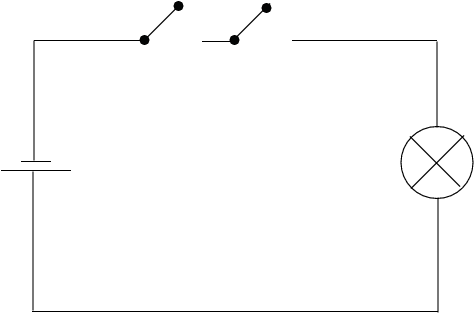

Das heißt, man hat die Besonderheit seines Organismus verwendet, um sich das Zählen beizubringen. Beim Entwickeln der Computertechnik hat man auf ein gut vertrautes System zurückgegriffen und es nur entsprechend modifziert. Die Hardware hat keine Finger, aber dafür elektronische Schaltungen, die zwei Zustände haben können: „Ein“ und „Aus“, die den beiden Ziffern des binären Zahlensystems entsprechen. „Die grundlegenden Funktionen, die im Computer stattfinden, lassen sich sehr leicht als elektrische Schaltpläne darstellen.“3

| 1 | 2 | Oder |

|---|---|---|

| 0 | 0 | 0 |

| 0 | 1 | 1 |

| 1 | 0 | 1 |

| 1 | 1 | 1 |

[Logisches Oder durch einfache Schalter]

Logisches Oder durch einfache Schalter4

[Logisches Oder durch einfache Schalter]

Logisches Oder durch einfache Schalter4

| 1 | 2 | Und |

|---|---|---|

| 0 | 0 | 0 |

| 0 | 1 | 0 |

| 1 | 0 | 0 |

| 1 | 1 | 1 |

[Logisches Und durch einfache Schalter]

Logisches Und durch einfache Schalter5

[Logisches Und durch einfache Schalter]

Logisches Und durch einfache Schalter5

0 und 1 lassen sich also in eine für die Hardware verständliche Sprache übersetzen. Größere Zahlen bekommt man, wenn man mehrere Nullen und Einsen zusammensetzt, genauso wie man es vom Dezimalsystem kennt. Es bleibt herauszufinden, wie man andere Informationen umwandeln kann.

Für einen Text ist es relativ einfach. Genauso wie in der Cäsar-Verschlüsselung kann man jedem Zeichen eine Zahl zuordnen. Es gibt deswegen sogenannte Kodierungen, Tabellen, die die Konvertierung zwischen den Zahlen und den Zeichen einer Schriftsprache ermöglichen. Eine der ältesten Kodierungen, die aber für die moderne Verhältnisse oft nicht mehr ausreicht, ist ASCII. Sie besteht aus 128 Zeichen, darunter sind sowohl die Buchstaben des lateinischen Alphabets (groß und klein separat), als auch Satzzeichen (Punkt, Komma und so weiter), als auch solche wie das Leerzeichen oder der Zeilenumbruch. Da man sehr bald einsehen musste, dass man vielmehr Zeichen braucht, um nicht englische Texte kodieren zu können, sind weitere Zeichenkodierungen entstanden wie UTF-8, UTF-16 oder UTF-32, wobei es auch viele anderen gibt (windows-1251, koi8-r und so weiter).

| 97 | 98 | 99 | 100 | 101 | 102 | 103 | 104 | 105 | 106 | 107 | 108 | 109 | 110 | 111 | … |

| 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | : | ; | < | = | > | … |

| 65 | 66 | 67 | 68 | 69 | 70 | 71 | 72 | 73 | 74 | 75 | 76 | 77 | 78 | 79 | … |

| A | B | C | D | E | F | G | H | I | J | K | L | M | N | O | … |

| 97 | 98 | 99 | 100 | 101 | 102 | 103 | 104 | 105 | 106 | 107 | 108 | 109 | 110 | 111 | … |

| a | b | c | d | e | f | g | h | i | j | k | l | m | n | o | … |

Darstellung der Graphik ist recht ähnlich. Zunächst muss man ein Bild in die einzelnen „Buchstaben“ zerlegen. Im Falle der Graphik nennt man so einen „Buchstaben“ ein Pixel. Ein Pixel ist ein Bildpunkt. Die Pixel sind so klein, dass das menschliche Auge gar nicht merkt, dass ein Bild aus sehr vielen Pixeln zusammengesetzt wird, obwohl vor 30 Jahren auf den alten Bildschirmen das noch zu sehen war. Da jedes Pixel eine eigene Farbe haben kann, muss jeder Farbe eine Zahl zugeordnet werden, die die jeweilige Farbe repräsentieren würde. Deswegen gibt es auch hier etwas etwas, was den Kodierungen der Buchstaben entpricht: Farbmodelle. Eines der am meistverbreiteten ist RGB (Red, Green, Blue). Die Farben entstehen aus Mischung der drei Grundfarben: Rot, Grün und Blau. Jeder der Grundfarben wird eine Zahl von 0 bis 255 zugeordnet, die der Intensivität der jeweiligen Farbe entspricht. Und man kann dann im Endeffekt jede Farbe als drei Zahlen jeweils von 0 bis 255 kodieren. Schwarz ist zum Beispiel [0, 0, 0] (alle Farben fehlen), Rot ist [255, 0, 0] (Rot hat den maximalen Wert, die anderen Farben sind nicht vorhanden), Gelb: [0, 255, 255] (Rot ist nicht vorhanden, Grün und Blau haben den maximalen Wert). Auch hier gilt es, dass es noch weitere Farbmodelle gibt, zum Beispiel CMYK.

Rot |

Grün | Blau | Schwarz | Weiß |

|---|---|---|---|---|

| (255, 0, 0) | (0, 255, 0) | (0, 0, 255) | (0, 0, 0) | (255, 255, 255) |

| Gelb | Pink | Dunkelgrün | Orange | Grau |

| (0, 255, 255) | (255, 192, 203) | (0, 100, 0) | (255, 165, 0) | (190, 190, 190) |

Die Übersetzung der Informationen, Wahrnehmungen in eine für den Computer verständliche Form (in die digitale Form) heißt Digitalisierung. Dementsprechend, wenn man ein Ereignis mit einer Digitalkamera aufnimmt, wird die Aufname digitalisiert.

In der Natur liegen alle Informationen zunächst in analoger Form vor: Das Bild, das Sie sehen, oder der Ton, den Sie hören, besitzt prinzipiell keine kleinste Informationseinheit oder Auflösung. Mit dieser Art von Informationen kann ein Computer heutiger Bauart nichts anfangen. Die besonderen Eigenschaften der Elektronik haben dazu geführt, dass Computer digital entworfen wurden. „Digital“ stammt vom englischen Wort digit („Ziffer“); dieses Wort ist wiederum vom lateinischen digitus („Finger“) abgeleitet, da die Finger von jeher zum Zählen eingesetzt wurden.6

Es gibt mindestens einen sprachlichen Zusammenhang zwischen dem Zählen, das nach Kapp eines der Produkte der Organprojektion ist, und der digitalen Technik. Wenn man aus dem Fenster schaut, zählt man nicht die einzelnen Farben und unterteilt nicht das Gesehene in die kleinsten Bestandteile. Es ist nicht bekannt, ob die Natur überhaupt in die kleinsten Bausteine zerlegt werden kann. Es gibt auch eine Reihe von Emergenztheorien, die behaupten, dass die Natur mehr ist, als die Summe ihrer Teile. Von der Emergenz spricht man, wenn auf höheren Ebenen der Entwicklung Eigenschaften entstehen, die auf niedrigieren Ebenen nicht vorhanden waren und die nicht auf etwas noch grundlegenderes reduzierbar sind.

Leben etwa ist eine emergente Eigenschaft der Zelle, nicht aber ihrer Moleküle; Bewusstsein ist eine emergente Eigenschaft von Organismen mit hoch entwickeltem Zentralnervensystem; Freiheit ist eine emergente Eigenschaft des menschlichen Organismus. Die einfacheren Lebensformen bilden zwar die Grundlage für die komplexeren; doch mit jedem Zusammenschluss zu einem neuen System entstehen auch qualitativ neue Eigenschaften, die es bei den vorangehenden Stufen noch nicht gab.“7

Wir nehmen solche Systeme als eine Ganzheit wahr. Ein schöner Baum vermittelt uns kein ästhetisches Gefühl mehr, wenn er in Moleküle oder Atome zerlegt wird. Computer degegen, um solche Eindrücke verarbeiten und speichern zu können, zerlegen sie sie in Informationseinheiten. Damit das Bild eines Baumes auf meiner Festplatte gespeichert werden kann, muss es in möglichst kleine Punkte, von denen jedem eine Farbe zugeordnet wird, zerlegt werden, diese Bildpunkte oder Pixel müssen dann abgezählt werden und dann können sie gespeichert werden. Deswegen macht die Abstammung des Wortes „Digitalisierung“ vom „Finger“ als dem Organ, das beim Zählen Abhilfe schuf, immer noch Sinn: Bei der Digitalisierung werden die Elemente, zum Beispiel eines Bildes, abgezählt, weil nur eine endliche Anzahl von Elementen aufgenommen werden kann, und dann gespeichert.

Andererseits, obwohl wir unsere Umwelt als eine Ganzheit wahrnehmen, besteht die Natur aus kleineren Bausteinen. Der menschliche Körper besteht aus Molekülen, Atomen, Elementarteilchen. Und genauso hat man die Welt der Informationstechnologien aufgebaut. Es gibt immer eine Informationseinheit (ein Buchstabe, ein Pixel), aus deren Zusammenstellung ein komplexeres Gebilde entsteht (ein Text oder ein Bild). Wie ein Atom aus Protonen, Neutronen und Elektronen besteht, können auch solche „Informationseinheiten“ weiter zerlegt werden. Der Buchstabe „A“ des lateinischen Alphabets hat den ASCII-Code 65. 65 ist größer als 1, ist also nicht direkt repräsentierbar. In der binären Darstellung enspricht der Zahl 65, die Zahl 0100 0001. 0 oder 1 in dieser Folge heißen ein Bit. Eine Folge aus 8 Bits ist ein Byte. Ein Bit ist die kleinste Einheit für den Computer. Man braucht also ein Byte, um 65 oder „A“ speichern zu können. Und dieses Byte ist in noch kleinere „Elementarteilchen“, Bits, zerlegbar. Wenn die Technik in der Tat die unbewusste Projektion des menschlichen Organismus sein soll, dann ist die Art, wie die Verarbeitung der Daten im Computer abläuft, noch ein Beleg dafür.

Der Organprojektion verdankt man nach Kapp die Fähigkeit zu zählen. Diese Fähigkeit hat dem Menschen ermöglicht die Welt zu ermessen. Man hat gelernt Gewicht und Abstand zu messen. Mit der Einführung des Geldes kann man den Reichtum messen. Und heute kann man auch Informationen messen. Für das Messen des Abstandes wurden Einheiten eingeführt wie Millimeter, Zentimeter, Meter oder Kilometer; für diese des Gewichtes — Gramme und Kilogramme. Um die Informationen digital darstellen zu können, müssen sie auch messbar sein. Die kleinste Informationseinheit ist ein Bit. Mit einem Bit ist nur ein 0 oder 1 darstellbar. Eine Folge aus 8 Bits ist ein Byte. 1000 Bytes (B) sind ein Kilobyte. 1000 Kilobytes (KB) sind ein Megabyte (MB). Es gibt dann Gigabytes (GB), Terrabytes (TB), Petabytes (PB) und so weiter. Es gibt auch Masseinheiten die auf Besonderheit der Computer-Technik abgestimmt und vom binären Zahlensystem abgeleitet sind: 1 Kibibyte (KiB) = 1024 (2) Byte, 1 Mebibyte (MiB) = 1024 KiB und so weiter. Aber die Grundlage bleibt immer dieselbe: Man hat ein Zahlensystem, das dazu verhilft, die Information „abzählbar“ zu machen, damit man sie digital verarbeiten kann.

Alte Prinzipien im Lichte der neuen Technik

Maßeinheiten, Zahlen, Zahlensysteme kannte man vor der Elektrotechnik. Mit der Entwicklung der Technik hat man nur gelernt, sie anders einzusetzen. Das kann einerseits rechtfertigen, dass die Spekulationen der Technikphilosophie nicht vergänglich sind, dass sie mit dem Fortschritt der Technik nicht notwendig veraltet werden. Andererseits kann es auch für die Organprojektion sprechen, weil der eigene Organismus dasjenige ist, was den Menschen durch seine Geschichte begleitet hat, sodass die Erkenntnisse, die er aus seinem Organismus gewonnen hat, bestehen bleiben und nur erweitert, korrigiert und neu angewendet werden.

Auch von der Möglichkeit, Texte zu „digitalisieren“, konnte man sehr früh Gebrauch machen, und zwar im Zusammenhang mit der Kryptographie, das heißt der Verschlüsselung und Entschlüsselung von Daten. Den Bedarf, Nachrichten verschlüsselt zu verschicken, gibt es wohl mindestens so lange, wie es Kriege gibt. Eines der ältesten Verschlüsselungsverfahren wird Cäsar zugeschrieben:

Julius Caesar is credited with perhaps the oldest known symmetric cipher algorithm. The so-called Caesar cipher — […] — assigns each letter, at random, to a number. This mapping of letters to numbers is the key in this simple algorithm.8

Was sich in den letzten Jahren geändert hat, ist, dass die Kryptographie nicht nur für bestimmte Gruppen (wie die Militär) interessant ist. Wenn man die Website seiner Bank, ein soziales Netzwerk oder seine Lieblingssuchmaschine besucht, werden die eingegebenen Daten verschlüsselt vor dem Versenden und dann am anderen Ende, vom Empfänger (der Bank, dem sozialen Netzwerk oder der Suchmaschine), entschlüsselt.

Bei der Cäsar-Verschlüsselung wird jeder Buchstabe eines geordneten Alphabets um mehrere Positionen nach rechts verschoben. „Verschieben“ heißt, einen Buchstaben mit einem anderen zu ersetzen, der Positionen weiter vorkommt. heißt dann Schlüssel (key). Zum Beispiel, wenn jedes Zeichen des Klartextes um 2 Positionen nach rechts verschoben werden muss, wird A zu C, B zu D, Z zu B usw. Um den Text dann wieder zu entschlüsseln, muss man die Anzahl der Positionen kennen, um die jedes Zeichen verschoben wurde, damit man das rückgängig machen kann (also um nach links verschieben). Dies ist ein symmetrischer Algorithmus, weil für die Verschlüsselung und die Entschlüsselung derselbe Schlüssel verwendet wird: Bei der Verschlüsselung muss man um Positionen nach rechts verschieben, bei der Entschlüsselung — um Positionen nach links.

Symmetrische Kyptographie wird immer noch weit eingesetzt. Wenn auch die modernen Algorithmen (Data Encryption Standard, Advanced Encryption Standard u.Ä.9) etwas komplexer sind, funktionieren sie sehr ähnlich:

With symmetric cryptography algorithms, the same key is used both for encryption and decryption. In some cases, the algorithm is different, with decryption „undoing“ what encryption did. In other cases, the algorithm is designed so that the same set of operations, applied twice successively, cycle back to produce the same result: […].10

Das heißt die Computerindustrie hat unsere Denkweise nicht kardinal geändert. Man hat mit der Technik nicht eine komplett neue Welt erschaffen, sondern man hat nach Wegen gesucht, erpobte Vorgehensweisen auf die neue Technik anzuwenden. Für die Techniktheorien, wie die von Kapp, kann es bedeuten, dass sie nicht komplett von der zu jeweiliger Zeit vorhandenen Technik abhängig. Ein vor Jahrtausenden entwickeltes Verschlüsselungskonzept findet immer noch Anwendung unter ganz anderen Bedingungen. Natürlich kann die Cäsar-Verschlüsselung nicht mehr eingesetzt werden, sie ist anfällig für die sogenannten „Brute-Force-Angriffe“: Ausprobieren aller möglichen Kombinationen oder Schlüssel. Für einen deutschen Text gibt es höchstens 30 Schlüssel, die man ausprobieren soll, um einen Text zu entschlüsseln (wenn man annimmt, dass das deutsche Alphabet 30 Buchstaben hat). Ein moderner Rechner kann diese Aufgabe in Sekunden lösen. Deswegen wurden Algorithmen entwickelt, die auch von einem Computer nicht so einfach rückängig zu machen sind, wenn man den Geheimschlüssel nicht kennt. Sie basieren aber auf derselben Grundlage und auch die kann man theoretisch durch das Ausprobieren aller möglichen Schlüssel umgehen, nur dass es auch für leistungstärkste Rechner Jahre und Jahrzehnte in Anspruch nehmen würde, dies durchzuführen.

Eric Kandel. „Auf der Suche nach dem Gedächtnis“

Wenn man eine Stufe tiefer geht und die Computertechnik auf der mechanischen Ebene betrachtet, findet man noch weitere Argumente für Kapps These. Bei einer oberflächlichen Betrachtung fällt einem sofort auf, dass die Computer komplexe Maschinen sind, die aus mehreren Bauteilen bestehen.

Die Hardware besteht grundsätzlich aus Zentraleinheit und Peripherie. Zur Zentraleinheit zählen vor allem der Mikroprozessor, der Arbeitsspeicher (RAM), die verschiedenen Bus- und Anschlusssysteme sowie das BIOS. Zur Peripherie gehören sämtliche Bauteile, die zusätzlich an die Zentraleinheit angeschlossen werden; sie dienen der Ein- und Ausgabe sowie der dauerhaften Speicherung von Daten.11

Der menschliche Organismus hat auch eine „Peripherie“, zu der die „Bauteile“ gehören, die der „Ein- und Ausgabe“ dienen. Ein Eingabegerät eines Rechners ist zum Beispiel eine Tastatur oder Maus. Man tippt etwas ein, die Informationen werden an die Zentraleinheit weitergeleitet und dort verarbeitet. „Eingabegeräte“ des menschlichen Körpers sind seine Sinnesorgane, unter anderem seine Augen und Ohren. Man nimmt die Informationen aus der Außenwelt auf und sie werden zu seiner „Zentraleinheit“ weitergeleitet und dort verarbeitet. Zu Ausgabegeräten zählen der Bildschirm und die Lautsprecher. Das „Ausgabegerät“ des Menschen ist beispielsweise sein Mundwerk.

Zur Zentraleinheit gehört der Mikroprozessor (Central Processing Unit, kurz CPU)12, „das eigentliche Herzstück des Computers, das für die Ausführung der Programme sowie für die zentrale Steuerung und Verwaltung der Hardware zuständig ist.“13 Das, was für die Maschine der Mikroprozessor ist, ist für den Menschen sein Gehirn: „[…] alle Zellen [haben] spezialisierte Funktionen. Leberzellen beispielsweise führen Verdauungsaktivitäten aus, während Gehirnzellen über bestimmte Mittel verfügen, Informationen zu verarbeiten und miteinander zu kommunizieren.“14

Der menschliche Körper besteht also aus verschiedenartigen Zellen, die für bestimmte Aufgaben zuständig sind. Man kann auch ein ähnliches Aufbaukonzept bei einem Rechner beobachten. Abgesehen vom Mikroprozessor kann er auch weitere Bestandteile wie die Grafikkarte oder Audiokarte, die zur Peripherie gehören, oder der Arbeitsspeicher, der ein Teil der Zentreinheit ist, haben.15 Und diese Bestandteile haben auch ihre spezifischen Funktionen, wie die Video- oder Audioverarbeitung.

Der Mikroprozessor ist allerdings das „Gehirn“ eines Rechners. Man kann sich einen Desktop-PC ohne eine Grafikkarte (der also nichts auf den Bildschirm ausgeben kann) kaum vorstellen. Es gibt aber auch die sogenannten Server, Computer, die bestimmte Dienste anbieten. Zum Beispiel, wenn man eine Webseite besucht, stellt man hinter den Kulissen eine Anfrage zu einem entfernten Computer, auf dem die Webseiteninhalte gespeichert sind. So ein Computer ist ein Beispiel eines Servers. Und solche Serversysteme bedürfen oftmals keine Bildschirmausgabe, ihre Aufgabe ist schlicht, die Anfragen der Benutzer anzunehmen, die richtigen Inhalte entsprechend der Anfrage auszusuchen und sie an den Besucher der Webseite schicken, damit er sie auf seinem Bildschirm sehen kann. Wenn ein menschliches Organ „defekt“ ist, seine Funktionen nicht mehr vollständig ausführen kann, dann führt es zu Einschränkungen der Lebensqualität. Daher gibt es blinde und taube Menschen. Wenn einige Teile eines Computersystems defekt oder nicht vorhanden sind, dann ist seine Funktionalität auch eingeschränkt, es kann zum Beispiel keinen Ton wiedergeben oder kein Bild ausgeben. Die Art der Einschränkung ist aber in den beiden Fällen nicht dieselbe. Kapp hat ja immer auf den Unterschied zwischen dem Organischen und Mechanischen hingewiesen, darauf, dass wir uns „des Andranges solcher Ansichten erwehren [müssen], welche den redenden, organisch gegliederten Menschen in den Räder- und Tastenautomat Hübners einsargen möchten“16. Hier tritt die Differenz zwischen dem Organischen und Mechanischen nochmal ans Licht. Ein Organismus ist ein Ganzes, eine Einheit, die nicht ohne ein Verlust zerlegt werden kann, hier ist das Ganze mehr als die Summe der Teile. Ein Mensch kann wunderbar ohne eine Lunge auskommen (wenn man eine Lunge im Folge einer Krebskrankheit verloren hat). Vielleicht muss man auf manche Sportarten in seinem Leben verzichten, aber wenn man sowieso keinen Sport treibt, kann es für manche Menschen irrelevant sein. Und trotzdem wird es als eine Einschränkung betrachtet, als etwas, was normalerweise nicht der Fall sein soll. Ein Mechanismus dagegen ist die Summe der Teile und nicht mehr als das. Er ist nach einem Plan gebaut, da gibt es nichts Unbekanntes: „Das physikalische Gesetz deckt allerdings vollkommen den Mechanismus, nicht aber den Organismus, den wir nur insoweit begreifen, wie wir mit jenem reichen“17. Das Fehlen einiger Komponenten in einem Serversystem, die in einem Desktop-PC vorhanden sind, wird nicht als eine Einschränkung betrachtet, solange der Server seine Aufgaben erfüllen kann. Das heißt, solange die Technik ihrem unmittelbaren Zweck dienen kann, ist sie durch das Fehlen einiger Komponente nicht eingeschränkt. Selbst wenn die Audiokarte meines Rechners kaputtgeht, ist das mehr eine Einschränkung für mich, weil ich keinen Ton habe, als für meinen Rechner.

Wenn zu Kapps Zeiten die Organtransplantation und die Medizin überhaupt den heutigen Stand der Entwicklung gehabt hätte, würde er bestimmt noch auf Folgendes aufmerksam machen. Wenn ein technisches Gerät kaputtgeht, kann man es je nach der Art des Defektes reparieren. Wenn ein Kabel reißt, kann man es meistens löten, sodass es weiterhin seine Funktion erfüllt. Wenn ein Teil komplexer ist, ist es oft günstiger, dieses Teil einfach auszutauschen. Nun könnte man mit Kapp argumentieren, dass die Medizin ihre Entstehung dem verdankt, dass der Mensch gesehen hat, dass er von ihm erzeugte Artefakte reparieren kann, und daraus geschlossen hat, dass es eine Möglichkeit geben muss, auch den Menschen zu „reparieren“. Und diese Erkenntnis kann sehr alt sein, da sogar so etwas Einfaches wie ein Hammer kaputtgehen kann. Als man komplexere Maschinen reparieren musste, könnte einem eingefallen sein, dass man auch den Organismus durch ersetzen der Organe heilen kann. Im Gebrauchtwarenhandel (e.g. eBay) sind seit einiger Zeit Geräte „für Bastler“ zu kaufen, das heißt kaputte Geräte, denen man aber noch funktionierende Teile entnehmen kann, um ähnliche Modelle wieder beleben zu können — die Möglichkeit, die einem Arzt durch das Vorhandensein eines Organspendeausweises bei einem Verstorbenen eröffnet wird.

Wie aber ein Mensch nicht ohne Gehirn leben kann, kann ein Computer nicht ohne den Mikroprozessor funktionieren. Eric Kandel, ein Gehirnforscher unserer Zeit, und ein Nobelpreisträger,18 schreibt in seinem Buch „Auf der Suche nach dem Gedächtnis“ über drei Prinzipien, auf denen die Biologie der Nervenzelle beruht:

Die Neuronenlehre (die Zelltheorie, auf das Gehirn angewandt) besagt, dass die Nervenzelle — das Neuron — der Grundbaustein und die elementare Signaleinheit des Gehirns ist. Die Ionenhypothese betrifft die Informationsübertragung innerhalb der Nervenzelle. Sie beschreibt die Mechanismen, durch die einzelne Nervenzellen elektrische Signale, so genannte Aktionspotenziale, erzeugen, die sich innerhalb einer gegebenen Nervenzelle über beträchtliche Entfernungen ausbreiten können. Die chemische Theorie der synaptischen Übertragung befasst sich mit der Informationsübermittlung zwischen Nervenzellen. Sie beschreibt, wie eine Nervenzelle mit einer anderen kommuniziert, indem sie ein chemisches Signal, einen Neurotransmitter, freisetzt. Die zweite Zelle erkennt das Signal und reagiert mit einem spezifischen Molekül, dem Rezeptor, an ihrer äußeren Membran.19

Bei jedem dieser drei Prinzipien handelt es sich um die Informationsübertragung. Der menschliche Körper ist ein komplexes System, dessen Untersysteme anhand von Signalen miteinander kommunizieren. Wenn ich etwas berühre, führt es zur Erregung einer Nervenzelle, die das Signal an andere Zellen und an das Gehirn weiterleitet. Funktional ist das derselbe Prozess, den man auch von Computern kennt: Wenn eine Taste der Tastatur betätigt wird, muss das über eine Kette der Signale dem Mikroprozessor mitgeteilt werden.

Auch der Sprachgebrauch der Neurobiologie verweist auf die Technik:

„[…] Nervenzellen [sind] innerhalb bestimmter Bahnen verknüpft, die er [Santiago Ramó y Cajal] neuronale Schaltkreise nannte.“20

„Schaltkreis“ ist ein Begriff, der aus der Elektrotechnik kommt und jetzt in der Neurobiologie Anwendung findet. Kapp ist auch zu seiner Zeit auf eine Reihe von Begriffen aufmerksam geworden, die zunächst zur Beschreibung der Artefakte verwendet wurden, dann aber für die Beschreibung des Organismus übernommen wurden:

Aus der Mechanik wanderten demzufolge zum Zweck physiologischer Bestimmungen eine Anzahl von Werkzeugnamen nebst ihnen verwandten Bezeichnungen an ihren Ursprung zurück. Daher spielen in der Mechanik der Skelettbewegungen Ausdrücke wie Hebel, Scharnier, Schraube, Spirale, Achsen, Bänder, Schraubenspindel, Schraubenmutter bei der Beschreibung der Gelenke eine angesehene Rolle.21

Es ist bemerkenswert, dass Kandel die elektrische Signalübertragung „die Sprache des Geistes“22 nennt: „ […] sie ist das Mittel, mit dessen Hilfe sich Nervenzellen, die Bausteine des Gehirns, miteinander über große Entfernungen verständigen.“23 Das heißt, dass das, was man der Computertechnik zugrunde gelegt hat, hat man dann in der Gehirnforschung wiedergefunden: Die Signalübertragung der anhand elektrischer Signale.

Hier endet allerdings die Ähnlichkeit der Funktionsweise nicht. Elektrische Signale werden bei der Computertechnik nicht einfach weiter, sondern auch nach Bedarf gestoppt. Zum Beispiel wird logisches Und mit einer Reihenschaltung mit zwei Schaltern realisiert.24 Wenn einer der Schalter geschlossen ist, wird das Signal gestoppt, was oder entsprechen würde. Bei den Nervenzellen kann man einen ähnlichen „Schaltmechanismus“ entdecken:

[…] nicht alle Nerventätigkeit [ist] erregend (exzitatorisch) […], dass also nicht alle Nervenzellen ihre präsynaptischen Endigungen dazu benutzen, die nächste Empfängerzelle in der Reihe zu stimulieren, damit sie die Information weiterleitet. Einige Zellen sind hemmend (inhibitorisch). Sie verwenden ihre Endungen dazu, die Empfängerzelle an der Weiterleitung der Information zu hindern.25

Des Weiteren kennen auch die Nervenzellen keine „schwächere“ oder „stärkere“ Signale:

Adrians Aufzeichnungen in einzelnen Nervenzellen zeigten, dass Aktionspotenziale dem Alles-oder-Nichts-Gesetz gehorchen: Sobald die Schwelle für die Erzeugung eines Aktionspotenzial erreicht wird, ist das Signal stets gleich — in der Amplitude wie in der Form26

Asymmetrische kryptographische Algorithmen und die Stellung des Menschen

Manche Anwendungsbereiche profitieren immer noch sehr stark von der ursprünglichen Tätigkeit der Rechner: dem Rechnen. Ein solcher Bereich ist die Kryptographie. Als nächstes möchte ich einen kryptographischen Algorithmus darstellen, der seit einigen Jahrzehnten erfolgreich im Internet eingesetzt wird. Mein Ziel dabei wäre, zu untersuchen, was die „Denkweise“ einer Maschine von der Denkweise eines Menschen unterscheiden kann. Kapp hat zwar versucht, die Organprojektion stark zu machen, aber hat trotzdem geglaubt, dass der Mensch nicht vollständig in eine Maschine projiziert werden kann, dass er immer Anlagen hat, die in der technischen Welt nicht vorkommen können.

Algorithmen, die mit einem Geheimwort, einem Geheimschlüssel arbeiten (sogenannte symmetrische Verschlüsselung) sind im Zeitalter des Internets nicht allein verwendbar. Das Problem ist, dass die beiden Seiten der Kommunikation einen Geheimschlüssel austauschen müssen. Wenn Sie eine E-Mail verschicken möchten, können Sie sie verschlüsseln, aber Sie müssen den Geheimschlüssel dem Empfänger mitteilen, damit er Ihre Nachricht auch entschlüsseln und lesen kann. Wenn Sie den Geheimschlüssel zusammen mit der Nachricht verschicken, dann geht die ganze Sicherheit verloren, weil, dann jeder, der den Zugriff zu Ihrer Nachricht bekommt, kann sie auch entschlüsseln. Um dieses Problem zu lösen, wurden „asymmetrische“ kryptographische Verfahren entwickelt. Sie operieren genauso wie die Cäsar-Verschlüsselung mit den Schlüsseln, aber für die Verschlüsselung und Entschlüsselung werden verschiedene Schlüssel verwendet (deswegen nennt man sie asymmetrisch). Deren Funktionsweise ist der der symmetrischen Algorithmen nicht ähnlich, weil ihnen bestimmte Eigenschaften der Zahlen zugrunde liegen. Streng genommen kann man mit deren Hilfe nur Zahlen verschlüsseln und die Tatsache, dass man viele Informationen in der Form von Zahlen darstellen kann, macht deren Verwendung überhaupt erst möglich.

„By far the most common public-key algorithm is the „RSA“ algorithm, named after its inventors Ron Rivest, Adi Shamir, and Leonard Adleman.“27

RSA ist relativ simpel. Dessen Sicherheit basiert nicht auf komplexen Formeln, sondern darauf, dass es mit sehr großen Zahlen operiert wird, sodass selbst die leistungsstärksten Rechner Jahrzehnte brauchen würden, um auf die richtige Antwort zu kommen, ohne den Geheimschlüssel zu kennen. Und das mit Einbeziehung der Tatsache, dass die Computer immer schneller werden.

Also für die Verschlüsselung und Entschlüsselung werden zwei Schlüssel verwendet, einen davon nennt man den öffentlichen Schlüssel (public key), den anderen — den privaten Schlüssel (private key). Der öffentliche Schlüssel heißt so, weil er öffentlich gemacht wird. Das eigentliche „Geheimwort“ ist der private Schlüssel. Stellen wir uns zwei Personen vor, Max und Sven, und Max will dem Sven eine E-Mail senden. Dafür muss Sven im Besitz der zwei oben genannten Schlüssel sein. Den öffentlichen Schlüssel stellt Sven dem Max und jedem anderen zur Verfügung, den privaten kennt nur er. Max verschlüsselt seine Nachricht mit Svens öffentlichem Schlüssel, verschickt sie, und nur der Besitzer des privaten Schlüssels, Sven, kann die Nachricht entschlüsseln. Der private Schlüssel wird zu keinem Zeitpunkt verschickt, der bleibt immer bei Sven. So verschwindet das Problem, das man mit der symmetrischen Kryptographie hat. Man muss nur zwei Schlüssel generieren können, die die Eigenschaft besitzen, dass, wenn man mit dem einen etwas verschlüsselt, allein der Besitzer des dazugehörigen privaten Schlüssels, es entschlüsseln kann.

Was sind diese Schlüssel eigentlich? Jeder davon besteht aus je zwei Zahlen:

und — Öffentlicher Schlüssel.

und — Privater Schlüssel.

Wenn die Nachicht ist, die verschüsselt werden soll, dann funktioniert es, wie folgt:

ist jetzt die verschlüsselte Nachricht. und gehören, wie oben beschrieben, zu dem öffentlichen Schlüssel. berechnet den Rest der Division geteilt durch . Bei der Entschlüsselung bedient man sich derselben Formel, nur wird mit (die Komponente des privaten Schlüssels) ersetzt:

Beispiel

Nehmen wir an, Max will Sven die PIN seiner Bankkarte „1234“ übermitteln. Sven hat Max seinen öffentlichen Schlüssel mitgeteilt (der aus 2 Zahlen besteht):

Der private Schlüssel von Sven (den nur er kennt, aber nicht Max) ist:

Max berechnet:

Sven bekommt und berechnet:

So kann Sven verschlüsselte Nachrichten empfangen, ohne seinen Geheimschlüssel jemandem mitteilen zu müssen.28 Wenn wir wissen, dass alle Informationen, mit denen ein Computer arbeiten kann als Zahlen repräsentierbar sind, kann man diese Vorgehensweise für jede vermittels eines Computers geschehende Kommunikation verwenden.29

In dem Beispiel oben wurden sehr kleine Zahlen verwendet. Aber selbst die Berechnungen mit diesen Zahlen sind für einen Menschen zu komplex (Das Ergebnis von hat über 3000 Stellen).

The security of the system relies on the fact that even if an attacker has access to and — which he does because they’re public — it’s computationally infeasbile for him to compute . For this to be true, and have to be enormous — at least 512 bit numbers (which is on the order of ) — but most public key cryptosystems use even larger numbers. 1,024- or even 2,048-bit numbers are common.30

Eine 512-Bit-Zahl ist eine Zahl bis , eine 1024-Bit-Zahl — bis , 2048-Bit — bis . Inzwischen wird oft empfohlen, 4096-Bit-Zahlen zu verwenden.

Diskreter Logarithmus

Der Modulus ist das Produkt zweier großer Zahlen und :

Danach muss man die Exponenten und so wählen, dass gilt:

Man schafft sich Abhilfe mit der eulerschen Funktion:

Danach wählt man und , sodass gilt:

The security in RSA rests in the difficulty of computing first the private exponent from the public key and the modulus as well as the difficulty in solving the equation for m. This is referred to as the discrete logarithm problem. These problems are both strongly believed (but technically not proven) to be impossible to solve other than by enumerating all possible combinations.31

Kreativität und Intuition

Die Tatsache, dass der Algorithmus funktioniert, verdankt also RSA nicht einer Kenntnis, sondern einer Unkenntnis, einem mathematischen Problem, für das man keine Lösung hat, von dem man glaubt, dass es keine Lösung hat; und im Zusammenhang mit der Sicherheit kann man vielleicht auch sagen, dass man hofft, dass man keine Lösung findet.

Menschliches Handeln, zumindest so, wie wir es erleben, basiert nicht nur auf Berechnungen. Der Mensch kann hoffen, glauben.

Davies schreibt im Bezug auf die asymmetrische Kryptographie Folgendes: „In general, public-key cryptography aims to take advantage of problems that computers are inherently bad at […].“32 Er behauptet, dass die Computer grundsätzlich schlecht im Lösen einiger mathematischer Probleme sind. Das stößt beim ersten Lesen auf Fragen. Eigentlich sind die Computer oft viel besser in der Mathematik als die Menschen. Computer Algebra Systems (CAS) sind Programme, die für die Arbeit mit algebraischen Ausdrücken entwickelt sind. Sie können alle möglichen Berechnungen durchführen und Gleichungen lösen. Aber das Lösen der Gleichungen muss einem CAS zunächst „beigebracht“ werden, es muss unterstützt sein, das heißt ein gewisser Algorithmus muss implementiert werden, nach dem die Gleichung gelöst werden kann.

Der Mensch sucht aber nicht nur nach Lösungen gewisser mathematischer Probleme, sondern auch nach Problemen selbst. Das ist ein kreativer Vorgang. Und bei manchen Problemen bleibt einem nichts anderes übrig, als sich auf seine Intuition zu verlassen, wie im oben aufgeführten Problem. Man muss auch in Betracht ziehen, dass man in dem Fall mit RSA viel Vetrauen seiner Intuition schenkt, weil die Wichtigkeit der Sicherheitssysteme für eine Informationsgesellschaft nicht zu unterschätzen ist. Das heißt man muss fest davon überzeugt sein, dass das Problem des diskreten Logarithmus zumindest nicht sehr bald gelöst werden kann.

Man kann im Bezug zu Maschinen nicht von der Kreativität, Intuition, einer Überzugung oder einem Glauben sprechen. Wir haben sie gebaut, wir wissen, wie sie funktionieren, wir wissen, dass sie nichts glauben. Selbst wenn wir von der Künstlichen Intelligenz sprechen, von den Maschinen, die selbst lernen, und die so viel gelernt haben, dass wir nicht mehr nachvollziehen können, wie sich die Maschine die einzelnen Inhalte beigebracht hat, so wissen wir zumindest, wie der Lernprozess selbst funktioniert, dass er nicht auf der Intuition, sondern auf der kalten Berechnung basiert.

Nun kann es natürlich sein, dass auch der Mensch nichts weiter als ein Bioroboter ist, der nur glaubt, dass er etwas glauben, von etwas überzeugt sein kann. Dann kann die Maschine den Stand des Menschen eines Tages einholen und ihn vielleicht sogar überholen. Das ist wohl das wichtigste und das stärkste Argument gegen Kapps Menschenbild. Dieses Argument hat allerdings auch problematische Seiten. Es sind ja die Menschen, die alles mit Bedeutung füllen. Ich kann mir auch nicht sicher sein, ob mein Nachbar etwas fühlt, hofft oder glaubt, oder ob er nur so tut. Erst wenn ich meinen Mitmenschen als solchen akzeptiere, schreibe ich ihm Eigenschaften zu, die ich selbst als Mensch zu besitzen glaube. Das heißt, wenn ein Roboter aus der Zukunft genauso aussieht, sich verhält, spricht wie ein Mensch, ist es immer noch zu wenig, ihn einem Menschen gleichzusetzen, zumindest, wenn der Mensch für mich nicht auf die physikalischen Eigenschaften reduzierbar ist.

Eine der Möglichkeiten, diesen Sachverhalt zu verdeutlichen, ist ein Gedankenexperiment, das den Namen „Chinesisches Zimmer“ bekommen hat, der „als Standardargument der Philosophie des Geistes und der Künstlichen Intelligenz betrachtet werden“ kann.33 Man stellt sich ein Computersystem, das chinesisch verstehen kann, es könnte beispielsweise Fragen auf Chinesisch beantworten, auf Aufforderungen reagieren und so weiter. So ein Programm würde chinesisch verstehen ohne es zu verstehen.34 Und das zweite „Verstehen“ ist eben in dem Sinne jenes Erlebnisses, das wir als Verstehen kennen, gemeint.

Ich behaupte hiermit nicht, dass dieses Argument den Status des Menschen als eines einzigartigen Wesens rettet; ich will viel mehr zeigen, dass die Frage nach dem Menschsein nicht durch die Entwicklung der Technik gelöst oder aufgehoben werden kann.

Würdigung

Kapps Theorie der Organprojektion ist umstritten. Sie hat ihre Schwächen. Diese Schwächen sind aber nicht dadurch entstanden, dass die Theorie zu alt für die moderne Technik ist, dass sie überholt ist. Genauso wie zu Kapps Zeiten stößt sie auch heute auf Kritik. Man kann sie genauso in der heutigen Zeit vertreten mit Einbeziehung neuer Entwicklungen, neuer Beispiele. In gewisser Hinsicht wird die Organprojektionstheorie durch den Umstand gestärkt, dass sie nicht auf die Zeit ihrer Entstehung beschränkt geblieben ist, sondern dass immer neue Tatsachen aufgetaucht sind, die ihrer Unterstützung dienen können.

Die Mechanisierung schreitet fort. Immer noch ist der Streit laut zwischen denen, die glauben, dass der Mensch eine Maschine ist, die künstlich nachgebaut werden kann, und denen, die das menschliche Schaffen dem Schaffen der Natur unterordnen. Wobei die Teilung auf diese zwei Lager ist nicht so eindeutig. Vielleicht wird man tatsächlich eines Tages im Stande sein, einen Roboter zu bauen, der sich äußerlich und in dem, wie er handelt, vom Menschen nicht unterscheidet. Aber ist er deswegen mit einem Menschen gleichzusetzen? Hat der Mensch nicht etwas Immaterielles in sich? Einen Geist oder eine Seele? Die Antwort auf diese Frage kann unterschiedlich ausfallen. Für Kapp war der Mensch und die Natur etwas, was von der Technik nie nachgeholt werden kann. Die Entwicklung der Robotertechnik macht schwieriger zu vertreten. Und trotzdem dünkt es mich, dass man ihn nie als „nicht aktuell“ abtun kann. Schließlich hat die Frage nach dem Status des Menschen einiges gemeinsam mit der Gottesfrage. Wenn man als Beispiel das Christentum nimmt, ist es irrelevant, wie viel von der Natur man physikalisch erklären kann, Gott bleibt jenseits der Natur. Genauso kann es geglaubt werden, dass ein Teil des Menschen immer jenseits der physikalischen Welt liegt, oder dass der Körper sogar der „Kerker der Seele“ ist, der das Eigentliche im Menschen festhält, wie es bei Platon auftaucht35. Die Entwicklung der Technik beeinflusst die Anthropologie, aber es ist schwierig sich vorzustellen, dass jene diese überflüssig machen kann.

Die ersten Werkzeuge hatten viele Ähnlichkeiten mit den menschlichen Organen. Komplexere Maschinen waren immer weniger ähnlich, aber haben den Anfang ihrer Entstehungsgeschichte in den einfachen Werkzeugen. Es ist aufregend zu sehen, wie die äußerliche Ähnlichkeit jetzt zurückkehrt. Man baut Roboter, die Hände, Beine, die Struktur eines menschlichen Organismus haben, und die ähnlich wie Menschen lernfähig sind. Der Unterschied ist, dass laut Kapp der Mensch am Anfang seiner Geschichte sich unbewusst in seine Werkzeuge projiziert hat. Die Entwicklung der Roboter und der Künstlichen Intelligenz ist hingegen voll bewusst. Man schaut, wie der Mensch sich entwickelt, wie er lernt, wie er aufgebaut ist, und versucht das technisch zu reproduzieren. Aber das Streben selbst, auf diese Weise die Natur zu erklären, sie besser zu verstehen, ist bemerkenswert. Kapp hätte auch hundert Jahre später kaum weniger Argumente gehabt, um seine Theorie zu verteidigen.

S. Kersken, IT-Handbuch für Fachinformatiker: Der Ausbildungsbegleiter, Bonn 72015, 35.↩︎

E. Kapp, Grundlinien einer Philosophie der Technik: Zur Entstehungsgeschichte der Kultur aus neuen Gesichtspunkten, hg. von H. Maye und L. Scholz, Hamburg 2015, 75.↩︎

Kersken, IT-Handbuch für Fachinformatiker, 85.↩︎

Ebd. 86.↩︎

Ebd.↩︎

Ebd. 52.↩︎

R. Kather, Was ist Leben? Philosophische Positionen und Perspektiven, Darmstadt 2003, 93.↩︎

J. Davies, Implementing SSL/TLS Using Cryptography and PKI, Indianapolis 2011, 30.↩︎

Vgl. ebd.↩︎

Ebd.↩︎

Kersken, IT-Handbuch für Fachinformatiker, 115.↩︎

Vgl. ebd. 119.↩︎

Ebd.↩︎

E. Kandel, Auf der Suche nach dem Gedächtnis: Die Entstehung einer neuen Wissenschaft des Geistes, München 2006, 74.↩︎

Vgl. Kersken, IT-Handbuch für Fachinformatiker, 120.↩︎

Kapp, Grundlinien einer Philosophie der Technik, 101.↩︎

Ebd.↩︎

Vgl. Kandel, Auf der Suche nach dem Gedächtnis, 11–15.↩︎

Ebd. 75.↩︎

Ebd. 81.↩︎

Kapp, Grundlinien einer Philosophie der Technik, 71.↩︎

Vgl. Kandel, Auf der Suche nach dem Gedächtnis, 90.↩︎

Ebd.↩︎

Vgl. Kersken, IT-Handbuch für Fachinformatiker, 86.↩︎

Kandel, Auf der Suche nach dem Gedächtnis, 87.↩︎

Ebd. 94.↩︎

Davies, Implementing SSL/TLS Using Cryptography and PKI, 91.↩︎

Vgl. ebd. 114.↩︎

Am Rande erwähnt wird die asymmetrische Kryptographie nicht zur Verschlüsselung der eigentlichen Nachrichten verwendet, es ist zu langsam, um große Mengen an Informationen zu verschlüsseln, sondern sie wird nur für das Key Exchange verwendet. Die symmetrischen Algorithmen hatten das Problem, dass beide Kommunikationspartner denselben Schlüssel teilen müssen. Algorithmen, wie RSA, benutzt man, um den Schlüssel eines symmetrischen Algorithmus dem anderen Kommunikationspartner zu übermitteln. Danach wird die Kommunikation normalerweise symmetrisch verschlüsselt.↩︎

Ebd. 92.↩︎

Ebd. 130.↩︎

Ebd. 91.↩︎

M. Dresler, Künstliche Intelligenz, Bewusstsein und Sprache: Das Gedankenexperiment des Chinesischen Zimmers, Würzburg 2009, 8.↩︎

Vgl. ebd.↩︎

Vgl. Platon, Kratylos, hg. von M. Holzinger, Berlin 2013, 21.↩︎